La tecnología utiliza un código de tuberías y puntos clave para reconocer gestos. Además, el desarrollo se publicará para que pueda utilizarse en ideas creativas y aplicaciones.

La capacidad de percibir la forma y movimientos de las manos puede ser esencial para mejorar la experiencia de los usuarios en muchas plataformas. Aunque parezca difícil de creer, la lectura de las manos en tiempo real es desafiante para la visión inteligente. Sin embargo, ingenieros de Google lograron que el lenguaje de señas sea entendido por máquinas.

El pasado 19 de agosto la compañía anunció el lanzamiento de un nuevo enfoque para leer las manos implementado en MediaPipe, un marco jurídico de código abierto para construir tuberías o cadenas de procesos que gestionen datos perceptuales de diversas modalidades como video y audio.

Si bien es natural para las personas entender lo que se dice con las manos, para una computadora es un problema pues ambas extremidades tienen la habilidad de hacer gran variedad de gestos. En ocasiones, se tapan con el movimiento, y es ahí cuando la mayoría de los sistemas pierden la posición de los dedos y la palma de la mano.

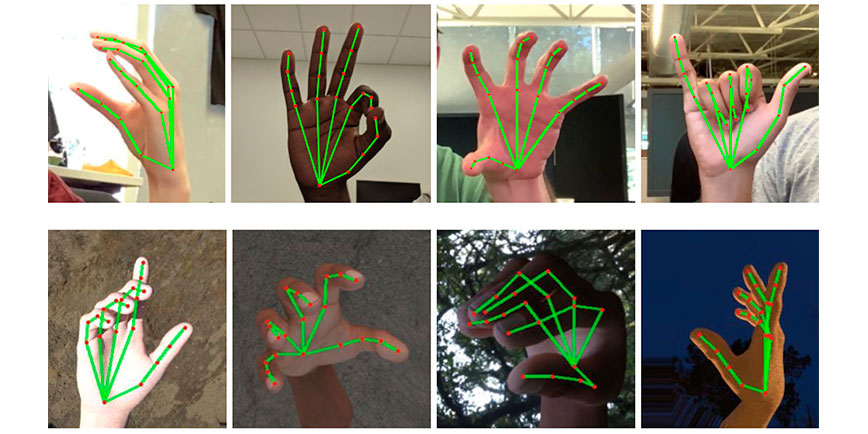

El nuevo enfoque proporciona un seguimiento de las manos y dedos en alta calidad mediante el aprendizaje automático. El sistema es capaz de inferir 21 puntos clave 3D de una mano desde un sólo cuadro o frame.

En pruebas, la metodología logró un rendimiento en tiempo real en un teléfono móvil, no sólo de una mano, sino de varias.

Funcionalidad

El laboratorio de Inteligencia Artificial de Google consiguió que el sistema forme una malla de puntos tridimensional que representa la posición de las articulaciones de las manos.

Gracias a que los resultados pueden leerse en tiempo real, lo único que falta para completar la lectura, es asociar las diferentes formas de las mallas de puntos con los significados.

La solución que permite que el lenguaje de señas sea entendido por máquinas, utiliza una tubería ML que contiene tres modelos que trabajan juntos:

- BlazePalm, el detector de palmas. Para identificar la ubicación inicial de la mano se utiliza un modelo de localización de disparo único optimizado para usos móviles en tiempo real. Logra una precisión promedio de 95.7% en la detección de la palma.

- Modelo de referencia manual. Al detectar la imagen anterior, el modelo de punto de referencia coloca con precisión las 21 coordenadas 3D que aluden a las articulaciones. Para obtener datos verdaderos, se cargaron manualmente 30 mil fotografías del mundo real.

- Reconocimiento de gestos. Además del esqueleto de la mano, se aplicó un algoritmo para derivar los gestos. La tubería desarrollada admite lenguajes de señas de la cultura americana, europea y china, además de varias señas como “pulgar arriba”, “puño cerrado, “ok”, “Rock” y “Spiderman”.

La arquitectura del proyecto es similar a la que se utiliza en las mallas de reconocimiento facial.

Futuras direcciones

Lograr que el lenguaje de señas sea entendido por máquinas da lugar al optimismo.

Google planea extender esta tecnología de manera estable y desea aumentar la cantidad de gestos que el mecanismo puede detectar de manera confiable. Además, la compañía publicará el desarrollo para que sea utilizado en ideas creativas y aplicaciones de los miembros de la comunidad de investigadores y desarrolladores en general.

Te puede interesar también:

“Microsoft busca eliminar las barreras de la discapacidad por medio de Inteligencia Artificial”

“Inteligencia Artificial, clave para tener una ventaja competitiva”