OpenAI confía en que los avances sus sistemas de seguridad y las políticas de la plataforma permitan a las personas usar imágenes con rostros humanos, sin hacer un mal uso de esta función.

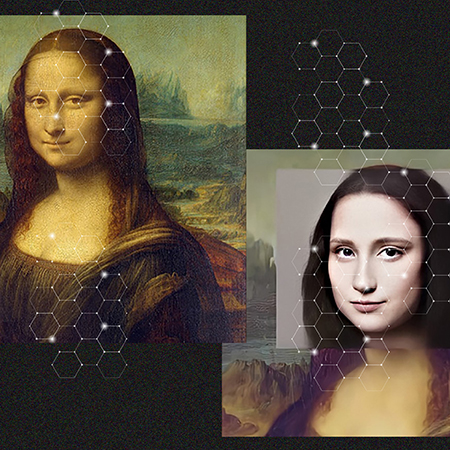

Después de que inicialmente OpenAI deshabilitara la función de editar rostros humanos por temor a uso indebido, la compañía creadora de DALL-E, un sistema impulsado por inteligencia artificial para la generación de imágenes a partir de texto, anunció esta semana que ahora los usuarios podrán subir imágenes de personas reales para modificarlas utilizando la tecnología de la compañía.

Anteriormente, OpenAI solo permitía a los usuarios trabajar con rostros fotorrealistas generados por la misma inteligencia artificial y prohibía el uso de cualquier foto que pudiera representar a una persona real, incluyendo imágenes propias, de celebridades, figuras públicas o famosos.

La nueva función de DALL-E

OpenAI explicó a sus usuarios, a través de un correo electrónico que su principal motivación para relanzar la función fueron las peticiones de sus clientes. “Muchos nos han dicho que extrañan usar DALL-E para crear y probar cientos de atuendos y peinados en ustedes mismos, así como editar los fondos de las fotos de sus familiares, por eso hemos construido nuevas técnicas de detección y respuesta para detener el uso indebido”, dijo la compañía.

La compañía además agregó en su comunicado ejemplos de algunos de los usos de la función de editar rostros humanos de DALL-E que podrían facilitar el trabajo de las personas. “Un cirujano plástico nos comentó que había usado DALL-E para ayudar a sus pacientes a visualizar los resultados de sus operaciones y los cineastas nos han dicho que quieren poder editar imágenes de escenas con personas para acelerar sus procesos creativos.”

Por ahora la herramienta atraviesa su etapa beta y solamente puede ser utilizada por los usuarios que hayan recibido una invitación para probarla.

DALL-E quiere asegurar la seguridad de sus clientes al editar sus rostros

OpenAI afirma que los últimos meses la compañía ha estado trabajando en mejoras de su sistema de seguridad que ayudan a minimizar el potencial de riesgo de deepfakes, que son falsificaciones profundas de los rostros para ponerlos en otro cuerpo y crear contenido político, sexual y violento, entre otras cosas. Es por eso que decidieron lanzar de nuevo la función que en sus inicios habían deshabilitado.

Además de lo anterior para garantizar un correcto uso de las imágenes, los términos y condiciones de servicio de DALL-E prohíben subir imágenes para las que los usuarios no tengan los derechos de autor o rostros de personas sin su consentimiento. Sin embargo, no esta muy claro que tan consistente y estricto ha sido históricamente OpenAI en el cumplimiento de sus políticas.

Por otro lado, la compañía cuenta con el respaldo de un gigante de la industria tecnológica como Microsoft y múltiples firmas de venture capital notables, incluyendo Khosla Ventures, por lo que tiene los recursos necesarios para invertir en un sistema de detección que garantice el uso correcto de las imágenes y evitar polémicas como en las que estuvo involucrado recientemente Stable Diffusion.

El mes pasado Stability AI lanzó al público un sistema de generación de imágenes de alta fidelidad disponible en un formato de código abierto, capaz de ejecutarse en hardware de consumo comercial sin ninguna restricción. No pasó mucho tiempo para que algunos usuarios comenzaran a utilizar Stable Diffusion, que también permite editar rostros humanos, para crear contenido sexual y publicidad no consensuada utilizando imágenes de artistas como Emma Watson y Taylor Swift.

No cabe duda que los generadores de imágenes a partir de textos impulsados por IA se están convirtiendo en una tendencia en el mercado, tanto Google, como Meta y hasta TikTok tienen el suyo. A medida que esta tecnología avanza y se vuelve más accesible a las personas, las plataformas que ofrezcan este servicio deberán asegurarse de establecer políticas y sistemas que aseguren su buen uso, ya que si no pueden poner en riesgo a miles de personas que pueden ser potenciales víctimas de una falsificación o mal uso de su imagen.