El CEO de OpenAI, respaldado por otros 350 investigadores, científicos y expertos de la IA exigen que se regule esta tecnología, advirtiendo que de no hacerlo, puede llegar a representar un “riesgo de extinción” para la humanidad.

Los principales líderes de la industria, incluyendo el CEO de OpenAI, Sam Altman, emitieron una declaración advirtiendo que la inteligencia artificial podría llegar a representar una amenaza para la existencia de la humanidad y se debería consider como uno de los riesgos sociales más serios de la actualidad, con el objetivo de hacer un llamado a los gobiernos de todo el mundo y autoridades correspondientes para que regulen esta tecnología en ascenso.

Los líderes consideran que es urgente abordar los riesgos de la IA lo antes posible, pues equiparan sus posibles peligros con los de amenazas nucleares y biológicas.

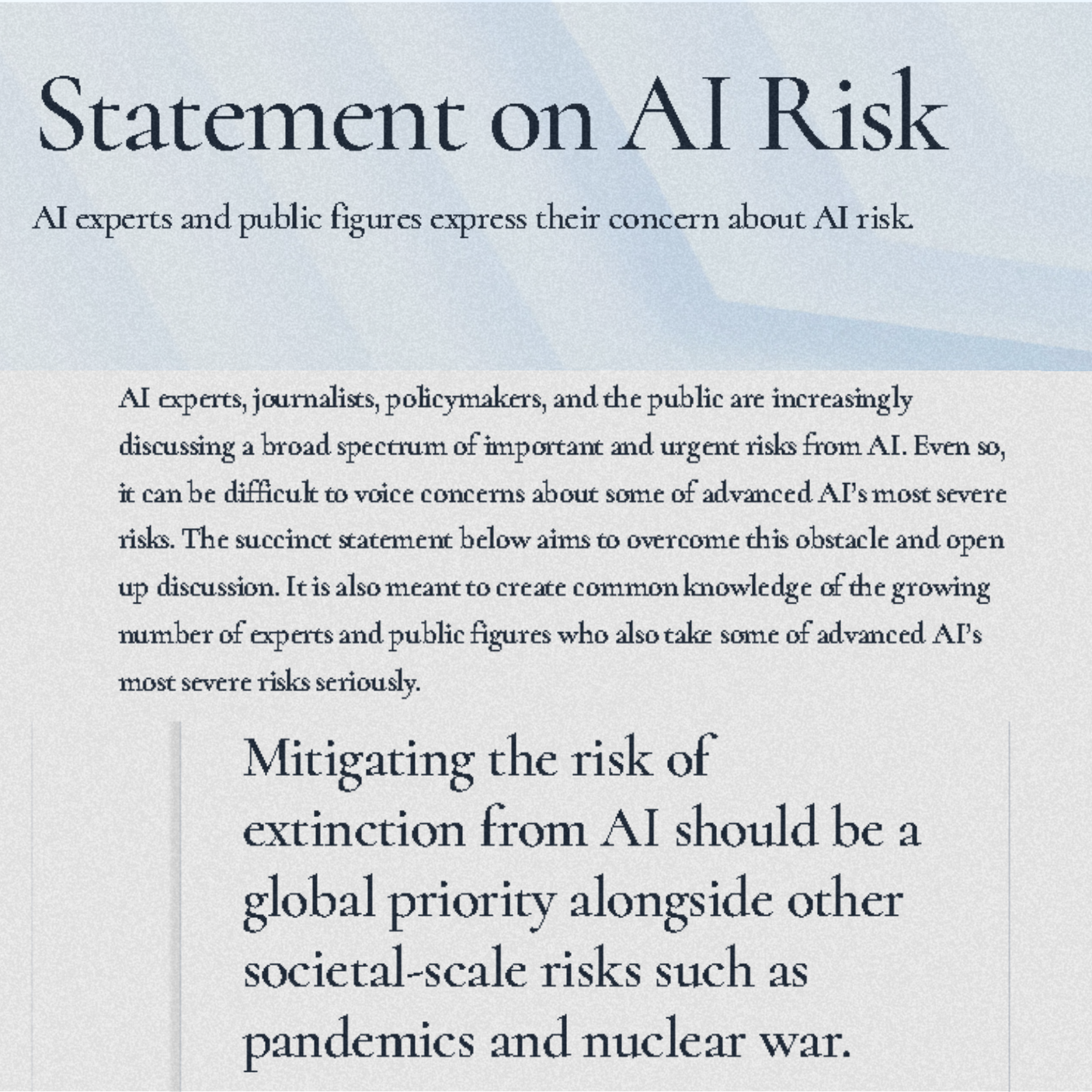

“Mitigar el riesgo de extinción para la humanidad que representa la IA, junto con otras amenazas a gran escala social, como posibles pandemias y una guerra nuclear, debe ser una prioridad mundial”, se lee en la carta pública que hasta ahora ha sido firmada por más de 350 ejecutivos, investigadores, científicos e ingenieros que trabajan en la industria de la inteligencia artificial.

En el preámbulo de la declaración, los autores mencionan que con su declaración buscan “abrir la discusión” entre los expertos de la industria, políticos, legisladores, periodistas y público en general, sobre los potenciales riesgos de la inteligencia artificial, con el fin de impulsar a los formuladores de políticas a centrar su atención en la mitigación de los peligros existenciales para la humanidad que plantea esta tecnología.

Por otro lado, señalan que a través de su mensaje también buscan demostrar a la sociedad la gran cantidad de expertos y figuras de peso en la industria que realmente toman en serio los riesgos para la humanidad de la IA avanzada.

Aunque los autores de la carta fueron concretos en su mensaje y no profundizaron en cómo la IA puede provocar la extinción de la raza humana, seguramente se refieran a la posibilidad de que, si no es abordada correctamente la capacidad cada vez mayor de autoaprendizaje que poseen los sistemas, las máquinas adquieran autonomía y se vuelvan prácticamente imposibles de controlar para los humanos.

¿Quién está detrás de la carta abierta?

La declaración fue publicada a través del sitio web del Centro de Seguridad de la IA o CAIS, por sus siglas en inglés, una organización sin fines de lucro con sede en San Francisco, respaldada por fondos de inversionistas privados.

Además del CEO de OpenAI, entre los firmantes se encuentran algunos de los directores ejecutivos de las firmas de IA más importantes en la actualidad como Demis Hassabis, quien funge como CEO de Google DeepMind y Dario Amodei, el cofundador y director ejecutivo de la startup Anthropic.

Otros destacados nombres que aparecen entre las firmas de la carta incluyen al ex ingeniero de Google Geoffrey Hinton y al científico de la Universidad de Montreal Yoshua Bengio, dos de los tres investigadores que ganaron un Premio Turing por su trabajo pionero en redes neuronales, considerados como los “padrinos de la IA” debido a sus contribuciones a la computación moderna.

Aumenta la preocupación respecto al potencial riesgo de la IA

Esta no es la primera carta en la que pesos pesados de la industria manifiestan sus preocupaciones respecto al desarrollo irresponsable de la inteligencia artificial.

A finales de marzo de este año, Elon Musk, junto a más de mil líderes mundiales, lanzaron una carta abierta solicitando a las grandes firmas y laboratorios del sector que detuvieran el desarrollo de modelos avanzados de IA por al menos seis meses, citando temores sobre los potenciales riesgos y peligros de esta tecnología si no es abordada de manera responsable.

A diferencia de la anterior petición, esta carta es un tanto más alarmante, indicándonos que a medida que la capacidad de la inteligencia artificial aumenta, también lo hacen las preocupaciones de los líderes en la industria, cada vez más conscientes de que urgen leyes que ayuden a mitigar los impactos adversos que esta tecnología potencialmente pueda provocar en la sociedad.

Afortunadamente para la causa de los investigadores que lideran el movimiento, recientemente se han visto avances hacia la regulación de la IA en distintas partes del mundo. La semana pasada la Unión Europea aprobó la primera propuesta de ley en el occidente para legislar la IA.

Mientras tanto, Elon Musk se ha reunido con diversos legisladores, incluyendo el líder de la mayoría en el Senado de Estados Unidos, Chuck Schumer, para discutir sobre la necesidad urgente de regular la inteligencia artificial en el país. Además de que, en el senado, ya se han presentado múltiples iniciativas de ley enfocadas en el control de esta tecnología, aunque ninguna se ha concretado.

Por su parte, Sam Altman actualmente está realizando una gira de trabajo por Europa, en la cual se ha reunido con diversos jefes de gobierno como los primeros ministros de España y Reino Unido, Pedro Sánchez y Rishi Sunnak respectivamente, así mismo con el presidente de Francia, Emanuel Macron para discutir sobre el futuro de la IA y las formas en que debe ser abordada.